YOLO5Face: Why Reinventing a Face Detector

论文:YOLO5Face: Why Reinventing a Face Detector

GITHUB: deepcam-cn/yolov5-face

摘要

Tremendous progress has been made on face detection in recent years using convolutional neural networks. While many face detectors use designs designated for detecting faces, we treat face detection as a generic object detection task. We implement a face detector based on the YOLOv5 object detector and call it YOLO5Face. We make a few key modifications to the YOLOv5 and optimize it for face detection. These modifications include adding a five-point landmark regression head, using a stem block at the input of the backbone, using smaller-size kernels in the SPP, and adding a P6 output in the PAN block. We design detectors of different model sizes, from an extra-large model to achieve the best performance to a super small model for real-time detection on an embedded or mobile device. Experiment results on the WiderFace dataset show that on VGA images, our face detectors can achieve state-of-the-art performance in almost all the Easy, Medium, and Hard subsets, exceeding the more complex designated face detectors. The code is available at https://github.com/deepcam-cn/yolov5-face.

近年来,使用卷积神经网络进行人脸检测取得了巨大进展。虽然许多人脸检测器针对检测人脸专门进行了设计,但我们把人脸检测看成是通用的目标检测任务。我们实现了一个基于YOLOv5目标检测器的人脸检测器,称之为YOLO5Face。我们对YOLOv5进行了一些关键修改,并针对人脸检测进行了优化。这些修改包括添加一个五点关键点回归head,在backbone输入使用一个stem block,在SPP中使用较小的kernel,以及在PAN块中添加一个P6输出。我们设计了不同型号尺寸的检测器,从实现最佳性能的超大型号到在嵌入式或移动设备上进行实时检测的超小型号。WiderFace数据集的实验结果表明,在VGA图像上,我们的人脸检测器几乎可以在所有Easy、Medium和Hard子集中实现最先进的性能,超过了更复杂的专用于人脸的检测器。代码已开源:https://github.com/deepcam-cn/yolov5-face。

概述

人脸检测(face detection)是许多人脸任务的第一步操作,这些任务包括人脸识别(face recognition)、人脸认证(face verification)、人脸追踪(face tracking,)、人脸配准(face alignment)以及表情分析(expression analysis)。论文参考TinaFace,把人脸检测任务看成是通用目标检测任务,人脸就是对象。

- 人脸的属性包括姿势(pose)、尺度(scale)、遮挡(occlusion)、照明(illumination)、模糊(blur),这些同样可以是对象的属性;

- 人脸独特的表情(expression)和化妆(makeup),可以看成是对象发生了遮挡和颜色的变化;

- 人脸上面的关键部位(landmarks,比如眼睛/鼻子/嘴巴),可以看成是对象的关键点;

- 人脸检测任务中遇到的困难场景,包括多尺度(multi-scale)、极小人脸(small faces)和密集场景(dense sences),同样存在于通用目标检测任务中。

论文设计的人脸检测器YOLO5Face,不仅仅针对大小人脸的检测,还实现了人脸关键点的检测,并且设计了不同大小和复杂度的模型,作用于不同计算资源的各个平台。

YOLO5Face

YOLO5Face是在YOLOv5的基础上进行的改造,YOLOv5网络结构可以分为Backbone、Neck和Head层,YOLO5Face在每个层都进行了小改造:

- 在Bakcbone层的输入增加了Stem block,替代原先的Focus层;

- Stem block是多分支操作,多分支计算的特征基于通道维度进行连接后输出

- 最新版本(v7.0)的YOLOv5实现已经取消了Focus层,使用多个卷积层进行通道升维;

- 在Backbone层的中间使用CBS block替代CSP block(C3)进行特征提取;

- 官方最新的YOLO5Face实现已经切换回CSP block了;

- 在Neck层的SPP模块中使用更小的核(

、 、 )进行池化操作,原先分别是 、 、 ; - SPP模块的设计有助于捕捉不同尺度的特征,能够增强模型对于物体尺度变化的鲁棒性;

- 将池化层的kernel变小,相对而言会关注于更小尺度的特征,这个应该是针对人脸场景的设计;

- 最新版本(v7.0)的YOLOv5实现使用SPPF替代了SPP模块,等同于SPP(k=(5, 9, 13))

- 在Head层增加了一个关键点检测HEAD,使用Wing loss进行关键点损失计算。

P.S. 论文仅考虑VGA输入分辨率的图像,也就是最大边长度是640大小。

训练

数据处理

通过实验,论文发现了某些预处理操作并不适用于人脸检测任务:

- 上下翻转(up-down flipping):YOLOv5默认的训练配置(

hyp.scratch-low.yaml)也不包含这一预处理; - 马赛克(Mosaic):

- 针对小目标人脸, Mosaic增强会退化性能;

- 不考虑小目标人脸, Mosaic增加有助于算法训练。

损失函数

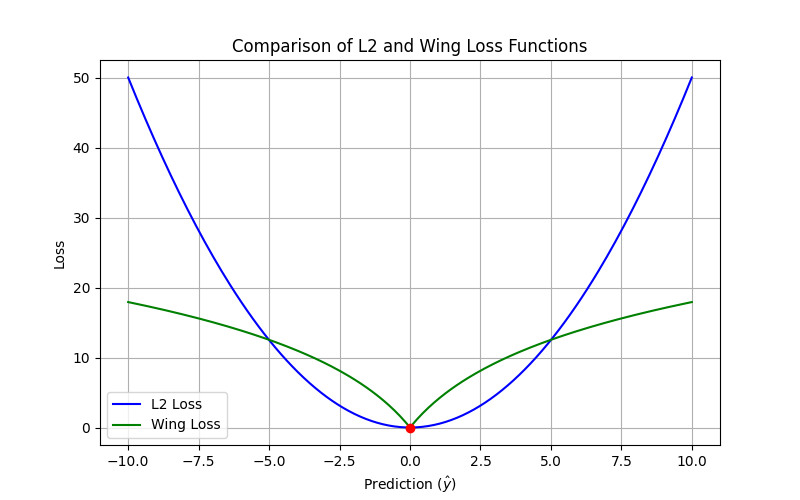

常用于关键点回归(landmark regression)的损失函数有L1/L2/smooth-L1,论文最终选择了Wing-loss,在预测坐标和真值坐标之间的误差较小时使用对数函数,在误差较大时使用线性函数计算损失值,这样可以减少异常值的影响同时保持损失函数对小误差的敏感度。实现公式如下:

是非负数,指定了非线性区域的取值范围是 ,实际训练设置为 ; 限制了非线性区域的曲率,实际训练设置为 ; 是平滑连接分段定义的线性和非线性部分的常数,计算公式是 。

1 | import numpy as np |

关键点回归HEAD检测5个关键点(两眼、鼻子、嘴角),那么关键点向量的长度是10,定义为

其中

实际训练中,权重参数landmark: 0.005)。

实验

小结

YOLO5Face对人脸检测任务进一步抽象,直接看成是通用目标检测任务,并且基于ultralytics/yolov5实现了多个有竞争力的人脸检测器。从论文的分析和实验来看,很多细分领域的检测任务都可以抽象成通用目标检测任务,比如人脸检测任务、车牌检测任务等。分析这篇论文,有两个现象值得讨论,

- 一个是为什么早期各个细分领域会出现各种深度学习定制算法?

- 其次是为什么随着深度学习的发展,各个细分领域的算法架构会趋向于统一?

在YOLO5Face发表之后yolov5工程还在不断的优化更新中,最终版本是yolov5-v7.0,我尝试着将YOLO5Face移植到最新版本的yolov5工程:zjykzj/YOLO5Face,从试验结果来看在WIDERFACE数据集上达到非常好的性能。

| ARCH | GFLOPs | Easy | Medium | Hard | |

|---|---|---|---|---|---|

| zjykzj/YOLO5Face (This) | yolov5s-face | 15.2 | 94.69 | 93.00 | 84.73 |

| deepcam-cn/yolov5-face(Official) | yolov5s-face | / | 94.33 | 92.61 | 83.15 |

| zjykzj/YOLO5Face (This) | shufflenetv2-face | 1.5 | 90.27 | 87.39 | 73.60 |

| deepcam-cn/yolov5-face(Official) | shufflenetv2-face | / | 90.76 | 88.12 | 73.82 |

| zjykzj/YOLO5Face (This) | yolov5x-v7.0 | 204 | 95.79 | 94.53 | 87.63 |

| zjykzj/YOLO5Face (This) | yolov5s-v7.0 | 15.8 | 94.84 | 93.28 | 84.67 |

| zjykzj/YOLO5Face (This) | yolov5n-v7.0 | 4.2 | 93.25 | 91.11 | 80.33 |